Il primo microprocessore, la storia infinita

Intel 4004, Four Phase AL1, Texas Instruments TMX 1795... Qual è stato il primo vero microprocessore? Forse non troveremo mai una risposta ma un'accurata ricostruzione della storia ci aiuterà a capire

Nella nostra nicchia di appassionati retrocomputeristi, ogni tanto si torna a discutere di quale sia stato veramente il primo microprocessore e delle conseguenze che ebbe su tutta l'industria dei computer. La recente presenza in Italia di Ray Holt, guest start degli eventi organizzati da Leo Sorge, ha contribuito a riaccendere un certo interesse.

Ray Holt terminò lo sviluppo dell'MP944 nel 1970, il processore che gestiva il sistema di volo del caccia F14, coperto da segreto militare fino al 1998. La storia è descritta sul suo sito web, First Microprocessor, nella sua biografia The Accidental Engineer e nel libro From Dust to the NanoAge.

L'MP944 era formato da sei integrati con tecnologia MOS/LSI che venivano utilizzati in diverse configurazioni per realizzare il sistema CADC (Central Air Data Computer).

Leo Sorge, noto scrittore e giornalista del settore, oltre a restituire la giusta notorietà al lavoro svolto da Holt, ci lancia una provocazione: "Cosa sarebbe accaduto se l'industria dei computer fosse stata a conoscenza del rivoluzionario chip MP944?"

Quel progetto ha anticipato quello che oggi chiamiamo Internet of Things: interrogava sensori ed elaborava dati in hardware, fornendo risposte in tempo reale.

Se fosse stata divulgata per tempo, la rivoluzione degli oggetti con una componente digitale (IoT) sarebbe arrivata per prima, rispetto alla rivoluzione di home e personal computer?

Tutto il settore avrebbe seguito questo cammino, eclissando i futuri microprocessori di Intel ?

Lo scopo di incuriosire i lettori è sicuramente raggiunto, ma se volessimo seriamente rispondere a questa domanda? La mia opinione è che, anche se non fosse stato coperto da segreto militare, il chip di Holt non avrebbe smosso l'industria, nemmeno di una virgola!

E ora proviamo ad allargare un po' il discorso, inquadrando storicamente la questione.

L'industria dei semiconduttori e la tecnologia MOS

Verso la fine degli anni '60, si faceva un gran parlare nel mondo tecnologico, in particolar modo nel settore dei semiconduttori, del fatto che sarebbe stato teoricamente possibile usare la nuova tecnologia MOS (Metal Oxide Semiconductor) per realizzare un unico chip che integrasse una molteplicità di funzioni.

Stava a significare che sarebbe stato possibile progettare e fabbricare un singolo circuito integrato sulla cui superficie erano presenti varie zone interconnesse fra loro, ognuna dedicata ad assolvere un compito specifico: un'unità aritmetico-logica, una ROM per memorizzare in modo permanente il software di base, una memoria RAM per contenere i dati in input e i risultati delle elaborazioni, la gestione dell'input/output e dell’alimentazione.

Un singolo chip che avrebbe potuto eseguire tutte quelle operazioni che solitamente richiedevano una motherboard su cui erano montati numerosi chip dedicati. I teorici battezzarono questo chip “microprocessore” — una CPU su singolo chip — poiché avrebbe assolto tutti i compiti dell'intera scheda che era comunemente usata come processore centrale di un calcolatore.

Non è possibile individuare un momento preciso della storia che condusse all'invenzione del microprocessore. "Non fu una vera e propria invenzione, nel senso tecnologico del termine", disse Gordon Moore, "La scoperta fondamentale fu la consapevolezza che finalmente era possibile realizzare ciò che tutti stavano dicendo che un giorno avremmo fatto".

All'inizio del 1969, il microprocessore varcò quel confine che esisteva fra la teoria e la reale fattibilità, e diverse aziende, dal gigante della comunicazione RCA al produttore di computer Four-Phase, iniziarono la loro marcia di avvicinamento verso quell'obiettivo.

Il microprocessore non fu una vera e propria invenzione, nel senso tecnologico del termine

C'era una lista infinita di ostacoli da superare: la progettazione, la realizzazione delle maschere, il processo produttivo, la dissipazione del calore, la programmazione, il packaging, i test di funzionamento, e molto altro. Se il concetto sembrava fattibile, nessuna azienda di semiconduttori avrebbe mai investito tante risorse in un progetto così ambizioso senza avere dei clienti sicuri a cui venderlo.

A quel tempo, alcune aziende avevano iniziato ad ottenere qualche risultato nello sviluppo del microprocessore; Rockwell, sotto contratto con la Difesa, aveva già dei prototipi, sebbene in una forma molto primitiva. La maggior parte di questi lavori erano coperti da segreto militare.

Chip general-purpose

Nel frattempo, l'industria aveva iniziato un dibattito per cercare di capire che direzione avrebbe preso lo sviluppo dei circuiti integrati dedicati alle calcolatrici. L'idea dominante era che in futuro si sarebbero realizzati dei chip custom per ogni cliente. Si pensava che fosse il modo migliore per aumentare le prestazioni dei dispositivi mantenendo nello stesso tempo il controllo sul prodotto grazie al design proprietario. Altri sostenevano che progettare dei nuovi chip per ogni calcolatrice sarebbe diventato — man mano che la Legge di Moore faceva il suo corso — sempre più complesso e costoso.

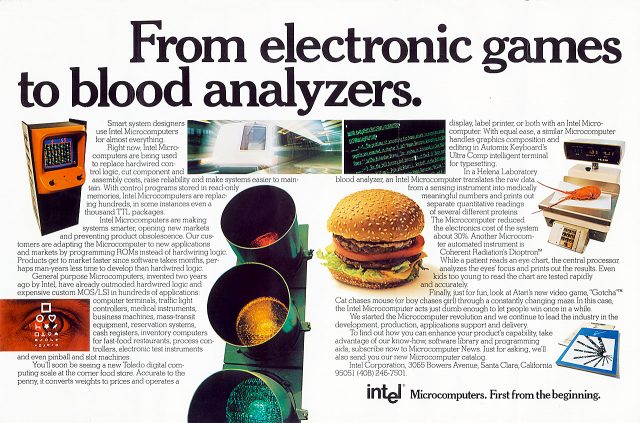

Per questo motivo, promuovevano una soluzione molto differente, derivata dall'industria dei computer: dei chip general-purpose che potevano essere programmati per svolgere diverse funzioni ed adattarsi così alle varie esigenze dei clienti.

In retrospettiva, la seconda strategia appare senza dubbio migliore. Non solo perché, come alcuni intuirono, sarebbe diventato presto esageratamente oneroso produrre dei chip custom, ma anche perché dei chip general-purpose, opportunamente riprogrammati, potevano essere impiegati anche in prodotti diversi dalle calcolatrici, in altri settori dell'elettronica di consumo.

Four-Phase System

Nel settembre del 1967, Lee Boysel scrisse un manifesto dove teorizzava che un intero computer (inclusa la memoria) poteva essere realizzato con la tecnologia MOS. All'epoca, nessun computer in produzione utilizzava la memoria a semiconduttori, MOS o bipolare che fosse. Proporre un computer basato interamente su tecnologia bipolare sarebbe già stato avveniristico, ma puntare sui circuiti integrati di tipo MOS era una scelta veramente radicale.

La maggior parte dei tecnici sosteneva che la tecnologia MOS avrebbe trovato la sua principale applicazione nelle calcolatrici da tavolo ma Boysel era convinto che, con i dovuti accorgimenti, si sarebbe potuta utilizzare anche per costruire un mainframe.

L'idea di Boysel era in netto contrasto con il mercato dei chip bipolari servito da Fairchild. Proponendo dei chip MOS ad alta integrazione, Boysel assorbiva gran parte del lavoro dei progettisti di computer, limitandone le scelte; questo fatto minacciava di scippare alle aziende produttrici di computer la loro principale fonte di valore aggiunto: il loro design proprietario.

Grazie all'uso dei circuiti a quattro fasi, che rendeva possibile l'uso di transistor MOS molto piccoli, Boysel fu in grado di realizzare dei chip con un livello di integrazione superiore a quello che aveva inizialmente stimato.

Four-Phase presentò il suo System IV/70 alla Fall Joint Computer Conference del 1970. Nel materiale pubblicitario che diffuse, Four-Phase comparava il System IV/70 all'IBM 360 model 30 come potenza elaborativa. Per quanto riguarda il processore, affermava soltanto che la scheda della

CPU contava complessivamente 75.000 transistor.

Il microprocessore AL1

Il cuore del Four-Phase System IV/70 era il chip AL1, che Boysel aveva concepito quando era ancora alla Fairchild. Il Four-Phase AL1 conteneva un'unità aritmetico-logica a 8-bit, otto registri da 8-bit e un program counter (un registro dedicato che conservava l'indirizzo di memoria della prossima istruzione da eseguire). Era un chip estremamente complesso, costituito da oltre un mille porte logiche su una superficie di 100 mm2 (per avere un'idea, impiegava quasi 4000 transistor, circa lo stesso numero dell'Intel 8008 che sarebbe stato introdotto due anni più tardi). Aveva una velocità di clock

prossima a 1 MHz e utilizzava un contenitore ceramico DIP (Dual In-line Package) a 40 pin, che Intel adottò solo a partire dall'8080.

All'epoca non esisteva alcun “microprocessore” o “computer su singolo chip”. Se qualcuno aveva utilizzato il termine “microprocessore” intendeva un diverso signifi cato: un processore programmato con del “microcodice” contenuto in una ROM.

Non esistendo dei criteri oggettivi per definire un circuito integrato come “computer su singolo chip”, se Boysel avesse fatto un annuncio altisonante per descrivere le innovazioni presenti nell'AL1, avrebbe potuto fregiarsi del merito di aver creato una nuova generazione di chip, prendendo in contropiede tutta l'industria dei semiconduttori.

Ma la realizzazione del chip AL1 non suscitò alcun clamore poiché per Four-Phase non rappresentava un'invenzione ma faceva parte di un normale percorso evolutivo.

In un articolo di Computer Design, nell'aprile del 1970, Boysel e il suo collega Joe Murphy, descrissero l'architettura del computer basato sui circuiti con logica a quattro fasi, sottolineando in particolare come i minicomputer avrebbero potuto trarre vantaggio della maggiore densità di integrazione che poteva garantire la tecnologia MOS.

Boysel e Murphy non fornirono una descrizione chiara e univoca del chip AL1, definendolo come “un componente low-cost frutto della quarta generazione di chip ad elevata integrazione”, “un'unità aritmetico-logica”, “una porzione da 8-bit del processore”.

Nell'aprile del 1970, al tempo in cui Federico Faggin stava appena iniziando lo sviluppo dell'Intel 4004, Boysel avrebbe potuto definire il chip AL1 nel modo che riteneva più opportuno per metterne in evidenza le sue peculiarità. Sebbene l'AL1 rappresentasse un raffinato lavoro di ingegneria, era solo uno dei tanti chip che Boysel aveva progettato per il suo sistema e, preso singolarmente, non lo considerava un'innovazione degna di nota.

Boysel aveva già progettato delle unità aritmetico-logiche quando era alla Fairchild e l'AL1 rappresentava semplicemente un'evoluzione di quel lavoro. Aveva spinto più in là il livello di complessità ma non lo considerava un cambiamento radicale. Per Boysel l’AL1 non era né un microprocessore né un computer su singolo chip. Principalmente perché il computer di Four-Phase aveva una parola lunga 24-bit e richiedeva tre chip AL-1 a 8-bit.

Inoltre, nella definizione di Four-Phase, l'unità di elaborazione centrale (la CPU), era costituita da una scheda in cui erano impiegati tre AL1, tre chip ROM e tre chip ‘Random Logic’.

Cosa si intende per "primo microprocessore"?

Il primo a essere progettato, il primo a essere prodotto, il primo a essere venduto o il primo a essere brevettato?

Il chip AL1 non rientrava nella definizione corrente di microprocessore.

Fu l'Intel 4004, introdotto nel 1971, a passare alla storia come il primo microprocessore. Intel lo annunciò trionfalmente come “un computer programmabile su singolo chip che apriva una nuova era dell’elettronica”. Boysel non pubblicizzò con altrettanta enfasi l'AL1. Come produttore di computer, ciò che più gli importava erano le caratteristiche del sistema nel suo complesso, come le prestazioni, il prezzo e la compatibilità.

Considerato che l'AL1 non apportava al computer delle caratteristiche che un cliente avrebbe potuto facilmente riconoscere come un vantaggio sui concorrenti, Boysel non aveva motivo di pubblicizzarlo come una novità.

Al tempo in cui i microprocessori Intel 4004 e 8008 esistevano solo su carta, mentre Four-Phase aveva già costruito un intero sistema basato sul chip AL1, Boysel affermò: “Il computer su singolo chip non è un traguardo così lontano. Noi siamo già scesi a nove chip e la tecnologia può essere ulteriormente affi nata. Non ho dubbi che un intero computer su singolo chip possa essere realizzato nel giro di cinque anni.”

Anche quando Four-Phase parlava di quanto fosse avanzata la sua tecnologia MOS, non lo faceva per promuovere le vendite del suo sistema perché per i clienti non aveva alcuna importanza sapere da quanti chip fosse costituita la CPU.

La storia del chip AL1 fornisce un interessante caso di studio sulle start-up della Silicon Valley in quel periodo cruciale. La differenza fra il lavoro di Four-Phase e Intel va osservata dal punto di vista industriale, tenendo conto del loro specifico settore di appartenenza.

Se condensare gran parte della potenza elaborativa di un processore su un chip non rappresentava un'invenzione per Four-Phase o l'industria dei computer, era invece un grande traguardo per l'industria dei semiconduttori.

Sebbene l'AL1 fosse sotto diversi aspetti tecnicamente superiore alla prima generazione di microprocessori Intel, l'appartenenza di Four-Phase all'industria dei computer ne condizionò fortemente lo sviluppo e la rigidità con cui era costruito ne limitò l'impiego nel System IV/70.

Al contrario, la flessibilità fu la caratteristica su cui puntò maggiormente Intel per i suoi microprocessori, consentendo ai propri clienti di sviluppare innumerevoli applicazioni attorno ad essi.

Da un certo punto di vista, il microprocessore non dovrebbe neanche essere considerato un'invenzione, ma piuttosto un qualcosa che si sapeva dovesse prima o poi concretizzarsi; era solo questione di aspettare la maturazione della tecnologia e del mercato.

“Se ne parlava ormai da diverso tempo. L’idea di condensare un computer su un singolo chip era una cosa abbastanza ovvia a cui l'industria dei semiconduttori sarebbe giunta”, dichiarò Ted Hoff, il progettista dell’Intel 4004. La domanda “Chi inventò il primo microprocessore?” potrebbe quindi essere priva di senso, se non in termini legali per i diritti sulla tecnologia.

Il primo microprocessore

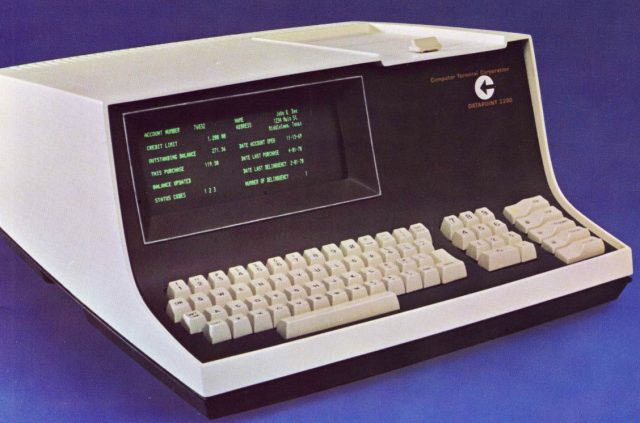

Alla fine degli anni ‘60, i chip MOS erano lenti, costosi e difficili da produrre. Per un computer era molto più vantaggioso impiegare una quantità di chip bipolari, e ciò era vero per qualsiasi tipologia, dal mainframe IBM System/360, al minicomputer PDP-11, a sistemi desktop come il Datapoint 2200.

All'inizio la tecnologia MOS sembrava indicata principalmente per dispositivi a basse prestazioni (calcolatrici e terminali) o quando era richiesta un'elevata densità dei transistor come nel caso dell'industria aerospaziale e delle calcolatrici tascabili.

Oltre a non esistere una definizione ufficiale di “microprocessore”, bisogna anche considerare cosa si intende per “primo”: ci si può riferire al primo a essere progettato, il primo a essere prodotto, il primo a essere venduto o il primo a essere brevettato.

Nella definizione comunemente accettata, è considerato un microprocessore una CPU su singolo chip che include l'unità aritmetico-logica (ALU), un program counter e i registri per ospitare i dati da elaborare. Sono sempre presenti chip esterni dedicati per RAM, ROM, I/O ed eventualmente altri chip di supporto come buffer e generatori di clock.

Secondo questa definizione, il Texas Instruments TMX 1795 può fregiarsi del titolo di primo microprocessore. Ma è probabile che, nel 1971, il termine “microprocessore” sia stato usato principalmente per esigenze di marketing, affinché aziende come Intel e Texas Instruments avessero a disposizione un'etichetta per identificare i loro nuovi prodotti.

Il 4 settembre 1973, Gary Boone, ingegnere di Texas Instruments, ottenne l'assegnazione del brevetto per l'architettura di un microprocessore a singolo chip.

Gilbert Hyatt, il titolare della semisconosciuta Micro-Computer Incorporated, aveva depositato il brevetto di una cpu su singolo chip nel 1969, prima che la sua azienda fallisse. A sorpresa, nel 1990 Hyatt riuscì ad ottenere il brevetto sul microprocessore. In seguito al ricorso di Texas Instruments, questo brevetto fu poi invalidato nel 1996 per il fatto che l'architettura di Hyatt non sarebbe stata realizzabile con la tecnologia disponibile nel 1970.

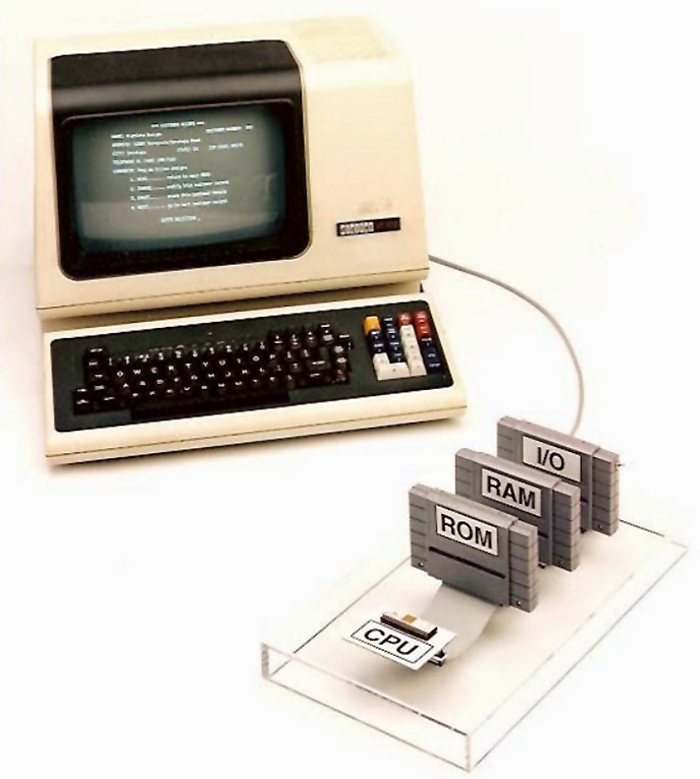

Anche Lee Boysel partecipò alla battaglia legale. Nel 1995, con un notevole esercizio ingegneristico, prese uno dei tre chip AL1 impiegati nella cpu a 24-bit del System IV/70 e presentò alla corte un microcomputer a 8-bit, aggiungendo gli altri chip dedicati, RAM, ROM e I/O, secondo la defi nizione brevettata da TI.

Il chip AL1 (uno dei primi esemplari prodotti nel 1969) era posto all'estremità di un bus di collegamento su cavo piatto; gli altri moduli erano alloggiati in cartucce intercambiabili (simili a quelle dei videogiochi Nintendo). Il sistema era assemblato in modo minimale su una lastra di plexiglass trasparente e non prevedeva altre componenti elettroniche, a parte l'alimentazione e un cavo seriale per collegare un videoterminale “stupido” DEC VT100.

La configurazione così ottenuta aveva lo scopo di dimostrare che l'AL1 poteva funzionare come microprocessore di un terminale “intelligente”, come il Datapoint 2200. Il software impiegato nella demo era una versione modificata di un programma sviluppato da CTC/Datapoint nel 1970 che permetteva la consultazione di un database, operazioni di data-entry e il trasferimento di stringhe di testo dalla memoria al display.

Era lo stesso software che CTC aveva fornito a Texas Instruments e Intel per verificare il corretto funzionamento del microprocessore che aveva commissionato secondo le proprie specifiche e da cui, senza cambiamenti significativi al set di istruzioni, sarebbero derivati sia il Texas Instruments TMX 1795 che l'Intel 8008.

Il Four-Phase AL1 non solo funzionò ma fece registrare delle performance nettamente superiori, paragonabili all'Intel 8080 di successiva generazione.

Dopo un’approfondita analisi si evinse che nella ROM era utilizzato del microcodice che sopperiva all'assenza di un program counter, gestiva le operazioni di lettura/scrittura e forniva all'AL1 l'indirizzo della prossima istruzione da eseguire. La corte legale, coadiuvata da uno staff di tecnici, concluse che l'AL1 veniva utilizzato come un'unità aritmetico-logica e non come un vero e proprio microprocessore.

CTC/Datapoint

Il terminale intelligente Datapoint 2200 aveva un'architettura a 8-bit ma in realtà operava come un “one-bit serial computer”, cioè in modo seriale, processando un bit alla volta. Poor aveva scelto di adottare quell'architettura semplificata perché voleva minimizzare il numero di componenti impiegati nel processore — immaginando che si potesse arrivare a realizzarlo in un unico chip.

“Il processore del Datapoint 2200 era effettivamente lento ma non rappresentava un problema, dopo tutto era concepito per un terminale programmabile che non necessitava di essere veloce”, disse Poor.

Sostanzialmente, Poor, Schmidt e Pyle concordano nell'affermare che la macchina che stavano sviluppando fosse un “terminale programmabile”, la cui caratteristica principale consisteva nell'emulare via software il funzionamento di vari dispositivi elettromeccanici come la Teletype Model 33 o la perforatrice IBM 029, o di altri videoterminali prodotti per funzionare con particolari modelli di computer. Lo scopo era allargare il mercato potenziale a cui CTC poteva ambire. Ma successivamente, come era nelle intenzioni iniziali di Roche e Ray, quel terminale programmabile finì per essere usato come un vero computer desktop.

A supporto di questa tesi, il Datapoint 2200 venne definito nei report interni della CTC come “computer general-purpose”.

I requisiti iniziali erano di ridurre quanto più possibile le dimensioni della circuiteria e del processore, affinché il Datapoint 2200 avesse lo stesso ingombro di una macchina per scrivere IBM Selectric, che era in quegli anni il dispositivo da ufficio più diffuso negli Stati Uniti.

Per la realizzazione del processore, Poor si rivolse ad Intel.

CTC era all'epoca uno dei più grossi clienti dell'azienda di Santa Clara, grazie alla fornitura degli shift register che erano usati per memorizzare il contenuto dello schermo dei Datapoint 3300. Di conseguenza, Poor ebbe la piena attenzione del fornitore.

“Parlai con diverse persone e capii che i manager di Intel non erano interessati alla realizzazione di piccole quantità di chip custom. Volevano produrre solo chip che potessero avere vasta diffusione, delle commodity smerciabili a più clienti”, ricorda Poor. Si offrirono di sviluppare una cpu a 4-bit (il futuro Intel 4004), originariamente commissionato da Busicom per una calcolatrice, ma Poor lo rifiutò considerandolo inadatto per i suoi scopi. L'ultima persona con cui si confrontò fu il progettista Stanley Mazor il quale si mostrò convinto di poterlo accontentare.

“Poor spiegò che stava progettando un processore a 8-bit e aveva bisogno di una memoria da 512 bit che integrasse uno stack, cioè di un registro dedicato alla cpu su cui venivano allocati dinamicamente i dati durante l’elaborazione”, disse Mazor. “La prima proposta che gli feci fu di realizzare un chip che integrasse 8 registri da 64-bit e lo stack. Ma potevamo fare di meglio e dissi che avremmo aggiunto anche un'unità aritmetico logica a 8-bit per operare sui dati contenuti nei registri. E visto che dal mese di settembre stavamo lavorando con Ted Hoff a una cpu a 4-bit, pensai che non sarebbe stato un salto così grande lavorare su un'architettura a 8-bit e realizzare l'intera cpu su un singolo chip. La mia proposta andava molto oltre le richieste di Poor, ma gli dissi che l'effettiva fattibilità dipendeva dal livello di complessità del suo processore, così rimanemmo d'accordo che mi avrebbe inviato una descrizione dettagliata con le specifiche e il set di istruzioni che aveva studiato.”

All'inizio del 1970, Poor e Mazor si incontrarono di nuovo e conclusero che il processore a 8-bit che doveva equipaggiare il Datapoint 2200 era tecnicamente fattibile. A quel punto, per dare seguito al progetto rimanevano da valutate le opportunità di business.

Qualche tempo dopo, Roche si recò in California per negoziare con il presidente di Intel, Bob Noyce, lo sviluppo del microprocessore. La proposta che avanzò Roche era semplice: Intel poteva usare il set di istruzioni del Datapoint 2200 e — senza costi di sviluppo per CTC — realizzare una cpu in grado di interpretare quelle istruzioni.

Intel avrebbe potuto vendere la cpu a chiunque ne fosse interessato.

Roche era convinto che un microprocessore del genere sarebbe stato accolto favorevolmente dal mercato, avrebbe consentito di dar vita ad una nuova generazione di prodotti e, se non altro, avrebbe ridotto l'ingombro e il calore generato dai circuiti, consentendo di far a meno delle rumorose ventole.

Genesi del primo vero microprocessore intel a 8-bit

La cpu a 4-bit che Intel stava sviluppando per Busicom avrebbe impiegato circa 2300 transistor; Roche era consapevole che il microprocessore a 8-bit per il Datapoint 2200 necessitava di un numero quasi doppio di transistor per condensare tutte le funzionalità su un unico chip (il prototipo del processore del Datapoint 2200 era realizzato su una scheda separata che contava circa 120 chip).

“Ciò che dici è interessante, si potremmo farlo”, disse Noyce, “ma è un prodotto che non rientra nella nostra strategia, non c’è abbastanza mercato per i microprocessori. Noi produciamo memorie, vendiamo

centinaia di chip di memoria ai produttori di computer. Se iniziassimo a produrre microprocessori potremo al massimo venderne uno per ogni computer, senza considerare il fatto che entreremmo in concorrenza con i nostri attuali clienti.”

Una cpu come l'Intel 4004 era vista sotto un’ottica completamente differente perché era destinata al mercato di massa delle calcolatrici, con volumi nettamente superiori. Complessivamente, si stimava che le esportazioni giapponesi arrivassero a sfiorare i 3 milioni di unità nel 1971. Inoltre, vendere microprocessori avrebbe significato anche dotarsi dell’adeguata struttura di supporto per i clienti che necessitavano inevitabilmente di molto più aiuto dal punto di vista ingegneristico e nell'implementazione del software.

Nel frattempo lo sviluppo del Datapoint 2200 andò avanti.

Il designer John Frassanito si trovò costretto a fare delle scelte senza essere sicuro dell'effettiva disponibilità del microprocessore. In particolare, la produzione di massa del cabinet del Datapoint 2200, una volta avviata, sarebbe stata molto costosa da modifi care. Per questo motivo, la base del cabinet fu indentata di mezzo centimetro per lasciare spazio alla scheda che ospitava il processore nel caso in cui la versione su singolo chip non fosse arrivata in tempo.

Nel marzo del 1970, Intel iniziò a lavorare alla cpu commissionata da CTC. Marcian Ted Hoff decise di non seguire alla lettera le specifiche di Roche: invece di un processore seriale, che operava su un bit alla volta, scelse di adottare un'architettura parallela. “Pensavo fosse più semplice seguire quella strada, anche se non avevamo mai realizzato un processore seriale, perché non c’era bisogno di tener traccia dei singoli bit, riassemblarli in un byte alla fine dell'elaborazione e mantenere il tutto sincronizzato”, racconta Hoff.

Il progetto del chip, battezzato 1201, venne affidato a Hal Feeney. La sigla numerica aveva un significato ben preciso: “1” stava a indicare che il chip sarebbe stato realizzato con processo produttivo p-MOS, “2” che era un chip “random logic” invece di un chip di memoria, mentre “01” signifi cava che era il primo prodotto di quella serie.

Feeney si occupò del 1201 mentre Federico Faggin portava avanti parallelamente lo sviluppo del 4004 (che secondo la nomenclatura adottata avrebbe dovuto chiamarsi 1202, ma Faggin insistette per

porre l’accento sull’architettura a 4-bit). Dopo pochi mesi, il 1201 rimase indietro nella tabella di marcia e, come discusso in precedenza, tutte le risorse vennero progressivamente spostate sul 4004.

I costi dei componenti TTL calarono enormemente nel 1970, arrivando in alcuni casi a costare fino a dieci volte meno. Dal punto di vista esclusivamente economico, i vantaggi di condensare la cpu in un unico chip erano praticamente svaniti.

La recessione continuava a mordere e CTC era in costante crisi di liquidità; quando cominciò a non pagare puntualmente la fornitura degli shift register per il Datapoint 3300, Intel fece slittare ulteriormente la priorità del 1201. CTC si trovava con l'acqua alla gola, al punto da considerare un lusso l'adozione del microprocessore.

Un altro fatto, non direttamente collegato alla CTC, influenzò la situazione. La Viatron Computer Systems Corp., fondata nel 1969 con una gran mole di investimenti, aveva fallito nel portare sul mercato il suo rivoluzionario sistema interattivo ed era finita in bancarotta nel marzo del 1971. Inoltre, la Viatron aveva usato il termine microprocessore per descrivere la sua a cpu e il suo fallimento aveva in qualche modo macchiato quella parola.

Agli occhi degli investitori, dopo le aspettative deluse dalla Viatron, un dispositivo basato su un microprocessore aveva assunto una connotazione negativa.

CTC preferì uscire sul mercato con la cpu-board, allentando la pressione su Intel. Inoltre, Feeney sembrava non avere le capacità per portare avanti autonomamente lo sviluppo della cpu 1201, mentre Faggin stava sperimentando con successo delle tecniche innovative sul 4004.

Quando Faggin, nel gennaio del 1971, ottenne i primi esemplari funzionanti del 4004, poté finalmente iniziare a occuparsi della cpu a 8-bit 1201 (che prese poi il nome di intel 8008)

L'attenzione sulla cpu a 8-bit si era infatti risvegliata, dopo che in quelle settimane Intel fu contattata dalla Seiko, che aveva manifestato interesse per il 1201. L'azienda giapponese voleva un chip del genere su cui basare una sua calcolatrice scientifica che potesse competere con la Hewlett-Packard 9100.

Noyce non era affatto convinto che una cpu su singolo chip fosse la strada da seguire per il futuro. I progetti rischiavano di diventare troppo complessi e costosi senza garantire un immediato ritorno economico. Come confidò Noyce, “Intel voleva completare lo sviluppo di quella cpu, più che altro per un senso di responsabilità.”

Il rapporto di CTC con Intel si incrinò ancora di più quando, il 7 giugno 1971, uscì la rivista Electronics Magazine, con una notizia che prese alla sprovvista l'intero settore. A pagina 36 il titolo dell'articolo recitava: “Il nuovo chip di Texas Instruments renderà un terminale una macchina indipendente”.

TI aveva evidentemente sganciato una bomba — e considerato il clamore suscitato alla Intel, aveva colto nel segno.

L'articolo descriveva il processore TMX 1795 di Texas Instruments che avrebbe potenziato le funzionalità del Datapoint 2200: “Grazie al chip monolitico, prodotto con tecnologia MOS e contenente circa 3100 transistor, il Datapoint 2200 sarebbe diventato il primo terminale remoto dotato di una capacità elaborativa locale che lo avrebbe reso indipendente da un mainframe.”

Texas Instruments aveva sviluppato questo chip LSI (Large Scale Integration) per la nuova versione del Datapoint 2200 che CTC avrebbe rilasciato a settembre. Il Datapoint 2200 era descritto come “un vero computer a 8-bit, con 8Kbyte di memoria, paragonabile per potenza a un DEC PDP-8, che non necessitava di essere connesso a un sistema in time-sharing”. Come l'Intel 4004, la cpu di TI avrebbe usato dei chip di memoria RAM appositamente realizzati per lavorare in accoppiata col processore.

Nonostante alcune affermazioni si dimostrarono poi esagerate, l'articolo fece cadere nel panico il team di Intel che si stava occupando del 1201 — sembrava che TI avesse avuto successo nel realizzare ciò che loro stavano provando a fare da più di un anno, il primo microprocessore al mondo per un computer. Comunque, dopo aver esaminato più attentamente la cpu di Texas Instruments, il team di Intel tirò un sospiro di sollievo: “Ci avevano battuti sul tempo, ma il loro chip era ridicolo. Era grande il doppio del nostro, consumava più energia ed era molto più costoso da produrre.”

Nell'estate del 1971, i primi esemplari del processore Texas Instruments furono inviati alla CTC per la valutazione. E ciò che si evinse fu che le affermazioni nell'articolo di Electronics Magazine risultarono per la maggior parte delle pure illusioni. Gli ingegneri di CTC non riuscirono a far funzionare la cpu. O meglio, come ricorda David Monroe, il tecnico a cui fu affidato il compito di testare la cpu Texas Instruments, “il processore rispondeva agli input ma non eseguiva alcuna elaborazione quando era accoppiato alla RAM dedicata. Quel chip aveva un voltaggio così stretto ed era così sensibile alla temperatura che risultava praticamente inusabile — era del tutto inaffidabile”.

Per tagliare i costi in quel periodo di recessione economica, Texas Instruments finì per chiudere il suo stabilimento di Houston che produceva chip con tecnologia MOS e tagliò definitivamente il progetto della cpu.

La storia non si chiuse perché il 31 agosto 1971, l'ingegnere della TI Gary Boone depositò un brevetto per la cpu su singolo chip che dette origine a una diatriba che si trascinò per decenni.

Verso la fine del 1971, con circa un anno di ritardo rispetto alla scadenza fissata inizialmente, Intel riuscì a produrre i primi esemplari del chip 8008. Nel frattempo CTC aveva deciso di andare avanti con la sua architettura proprietaria, imboccando una strada che, di fatto, avrebbe segnato il destino dell'intera industria dei computer.

Alcune versioni della storia sottolinearono il fatto che CTC rifiutò la cpu di Intel perché era notevolmente più lenta della cpu-board progettata da CTC, principalmente a causa della tecnologia MOS usata nel processo produttivo che rendeva i chip meno reattivi rispetto alla tecnologia bi-polare usata nei chip MSI (a media integrazione) che componevano la scheda CTC. “Sotto certi aspetti il chip 1201 era ormai inadeguato”, disse Poor, “aveva una velocità paragonabile alla prima versione del Datapoint 2200, ma le sue performance erano di circa due ordini di grandezza inferiori rispetto a quelle della versione II.”

Gus Roche trovava la cpu un progetto molto elegante dal punto di vista tecnico e avrebbe voluto mantenerne i diritti. “In ogni caso, usare il microprocessore non avrebbe reso più economico il costo del prodotto”, ricorda Frassanito, “così la volontà di Ray e Poor finì per prevalere nella sciagurata decisione finale.”

Gli argomenti di Poor sembravano convincenti: “La nostra tecnologia funziona più che bene, e ai clienti non interessa minimamente cosa ci sia dentro il case”. Troppo facile a dirsi con il senno di poi, ma la decisione di CTC si rivelò estremamente miope, consegnando a Intel le chiavi di un nuovo regno.

Microprocessore Intel 8080

Per la consacrazione del microprocessore fu necessario attendere la successiva generazione, in cui Faggin volle integrare tutte le migliorie suggerite dai clienti.

L'ulteriore miniaturizzazione, che agli osservatori esterni sembrava quasi miracolosa, era di fatto la parte più semplice. Come previsto dalla Legge di Moore, la tecnologia del processo produttivo era scesa a 6 micron e ciò rendeva possibile integrare su un solo chip fino a 5000 transistor, ben oltre i 3500 di cui era costituito complessivamente l'8008.

Come se non fosse abbastanza, Faggin era convinto di poter salire con la velocità di clock fino a 2Mhz e ciò significava che, con le giuste applicazioni software, il suo nuovo microprocessore a 8 bit avrebbe potuto eseguire più di un milione di operazioni al secondo — un livello di performance paragonabile a quello dei più diffusi minicomputer.

Per velocizzare il trasferimento dei dati in input/output, fu decisiva la scelta di adottare un packaging con un numero maggiore di contatti.

“Realizzare un chip con più di 16 pin sembrava un'eresia all'Intel”, racconta Faggin. “Tutti i chip di memoria utilizzavano un packaging standard a 16 pin. Per il 4004 e l'8008 utilizzammo un DIP (Dual In-line Package) a 18 pin e la novità fece storcere il naso a molti. Con l'8080 decisi di aumentare il numero di pin a 40 pin per gestire separatamente un bus dati a 8 bit e un bus indirizzi a 16 bit”.

Rispetto ad altri sistemi dell'epoca che erano ‘multiplexati’ (che utilizzavano gli stessi pin per funzioni diverse, ad esempio per far passare sia gli indirizzi che i dati, costringendo a utilizzare una logica esterna per “separare” queste informazioni), la caratteristica introdotta da Faggin permetteva di semplificare notevolmente il layout delle schede madri, riducendo al minimo la necessità di chip di supporto. Ovviamente ciò comportava un costo più elevato per il microprocessore, poiché il package risultava più grande dovendo contenere un più elevato numero di piedini.

Faggin voleva anche aggiungere un maggior numero di istruzioni nella ROM integrata e adottare una nuova e più efficiente tecnologia per i transistor chiamata silicon-gate n-channel (a canale negativo), al posto del tradizionale p-channel.

Nella primavera del 1972, mentre Intel annunciava formalmente la disponibilità dell'8008, Faggin propose al management il progetto del suo nuovo microprocessore a 8-bit, che avrebbe preso il nome di Intel 8080.

L'adozione di questo microprocessore da parte dei primi produttori di microcomputer in kit, più che un risparmio sui costi, segnò una discontinuità netta con le precedenti architetture derivate dai minicomputer. Il vantaggio principale di cui beneficiarono gli hobbisti fu la possibilità di lavorare a dei progetti che, grazie a quel nuovo componente, apparivano notevolmente semplificati.